vllm을 설치하고 실행해보자.

vllm은 기본적으로 CUDA 11.8 이상이 필요합니다.AMD GPU는 현재 공식적으로 지원되지 않으므로 NVIDIA GPU 사용을 권장.

https://github.com/vllm-project/vllm/blob/main/vllm/entrypoints/llm.py

vllm/vllm/entrypoints/llm.py at main · vllm-project/vllm

A high-throughput and memory-efficient inference and serving engine for LLMs - vllm-project/vllm

github.com

1. Python 3.10 설치 (Windows)

python --version # Python 3.10.x가 출력되어야 함

2. NVIDIA Drivers 설치

https://www.nvidia.com/en-us/drivers/

Download The Latest Official NVIDIA Drivers

Download the latest official NVIDIA drivers to enhance your PC gaming experience and run apps faster.

www.nvidia.com

2. CUDA Toolkit 설치

https://developer.nvidia.com/cuda-downloads

CUDA Toolkit 12.1 Downloads

Get the latest feature updates to NVIDIA's proprietary compute stack.

developer.nvidia.com

3. WSL 업데이트 (최신 버전 설치)

Windows 환경에서 vllm 설치가 지속적으로 실패할 경우, WSL 2 (Linux 환경) 사용이 더 안정적입니다.

WSL 2는 NVIDIA CUDA를 네이티브처럼 사용할 수 있도록 지원

PowerShell 관리자 모드로 실행

최신 버전의 WSL 설치:

wsl --updatewsl --shutdown

WSL 버전 확인:

wsl --version

기존 레거시 Ubuntu 제거 (선택 사항)

레거시 버전을 제거하려면:

wsl --unregister Ubuntu

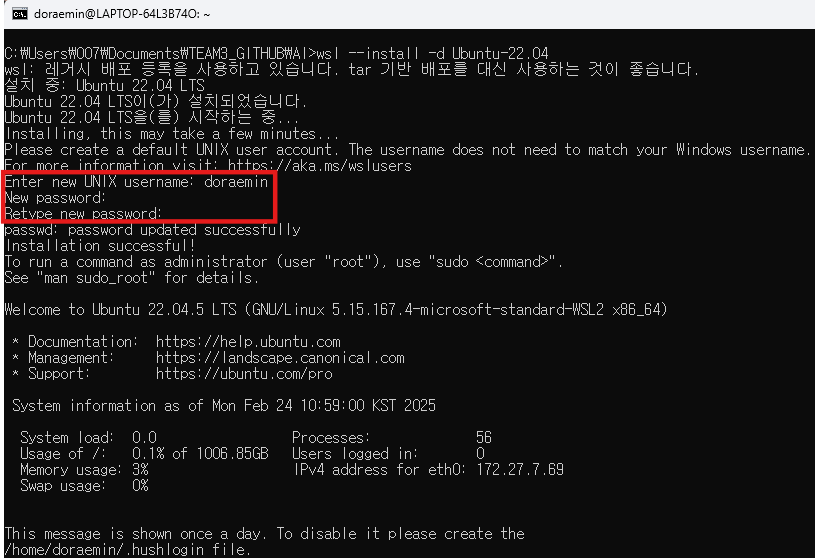

새로 Ubuntu 22.04 설치

wsl --install -d Ubuntu-22.04

다음부터는 명령어 'wsl'만 입력하면 곧바로 접속 된다.

✅ WSL 2 (Ubuntu 22.04) 설치 성공! 🚀

이제 vllm을 설치할 준비가 완료되었습니다.

아래 순서대로 명령어를 입력해 주세요.

0. 가상환경

# 홈 디렉토리에서 생성 # 홈 디렉토리에 설치하면 어떤 폴더에서도 접근 가능하여 관리가 쉽습니다.

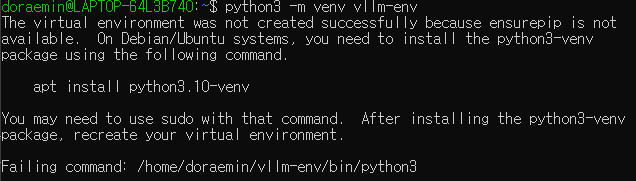

python3 -m venv vllm-env

# 가상환경 활성화

source vllm-env/bin/activate

# 활성화 후 프롬프트:

(vllm-env) doraemin@LAPTOP-64L3B74O:~$

python3 -m venv 명령어 실패 에러 발생 시 아래의 '접은글' 참조

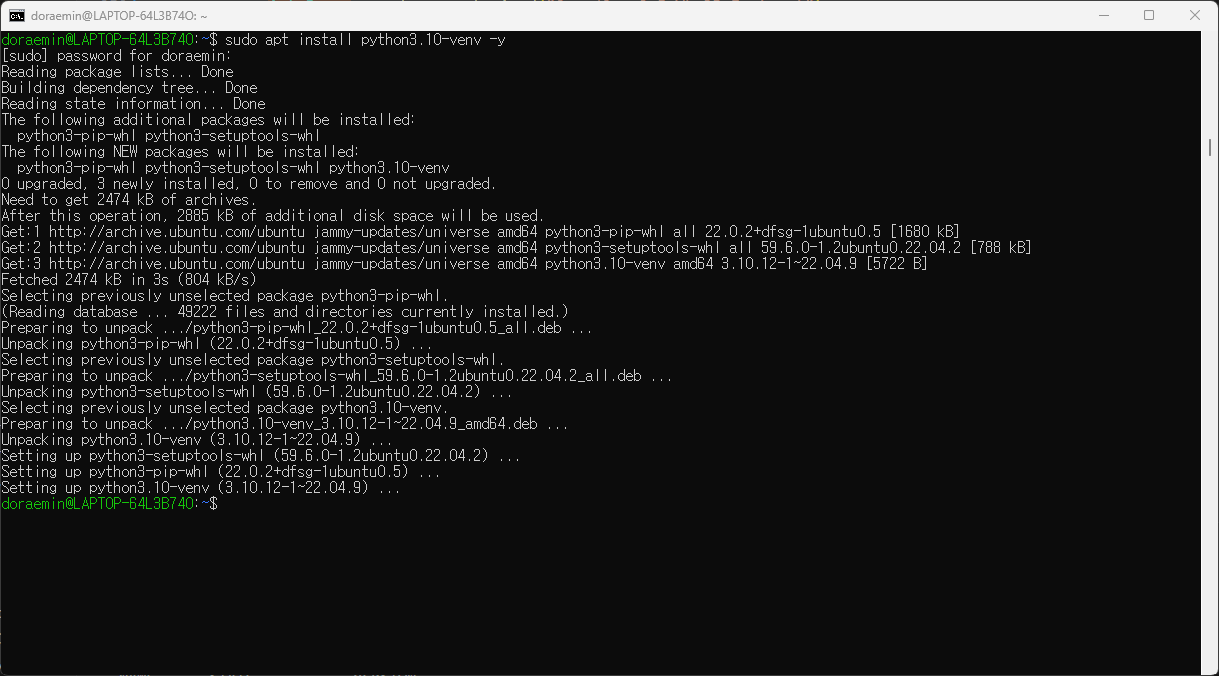

python3-venv 설치:

sudo apt install python3.10-venv -y

💾 1. 시스템 업데이트

먼저 패키지 목록을 업데이트합니다:

sudo apt update

sudo apt upgrade -y

pip install --upgrade pip setuptools wheel🐍 2. Python 및 Pip 설치

- Python 3 및 Pip 설치:

sudo apt install python3 python3-pip -y

- Python 버전 확인:

python3 --version

Python 3.10 이상이 표시되면 됩니다.

🔧 3. NVIDIA CUDA 및 PyTorch 설치

- NVIDIA CUDA 드라이버가 작동 중인지 확인:

nvidia-smi

- 정상적으로 출력되면 GPU가 WSL 2에서 사용할 준비가 된 것입니다.

- PyTorch 설치 (CUDA 지원 버전)

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

- CUDA 11.8을 사용하는 버전이 더 안정적입니다.

🧪torch 테스트 (작동 확인)

Python을 열고 다음 코드를 실행하세요:

import torch

print("CUDA 사용 가능 여부:", torch.cuda.is_available()) # True가 나오면 CUDA 사용 가능

print("GPU 이름:", torch.cuda.get_device_name(0)) # NVIDIA GPU 이름 출력📦 4. vllm 설치

이제 드디어 vllm을 설치합니다:

pip install vllm[cuda]

또는 CUDA 버전을 명시하려면:

pip install vllm[cuda11.8]

설치 완료 시 더 이상 AMD ROCm 관련 오류가 발생하지 않습니다. 🎉

🧪 vllm 테스트 (작동 확인)

Python을 열고 다음 코드를 실행하세요:

from vllm import LLM

llm = LLM(model="Qwen/Qwen2.5-VL-3B-Instruct")

print("vllm이 성공적으로 로드되었습니다!")💎 결론

- 이제 WSL 2 환경에서 vllm을 사용할 준비가 모두 완료되었습니다.

- 더 이상 AMD ROCm 관련 오류가 발생하지 않으므로, NVIDIA RTX 4090의 CUDA 가속을 활용할 수 있습니다. 🚀

이제 내 코드를 실행하려니, 버전이 안 맞는 에러가 발생했다.

TensorFlow가 GPU를 사용하려고 시도했으나, CUDA 또는 cuDNN 라이브러리 초기화에 실패했습니다.

tensorflow.python.framework.errors_impl.FailedPreconditionError: Graph execution error와 DNN library initialization failed

https://doraemin.tistory.com/145

[WSL] CUDA Version Downgrade

wsl을 통해 코드를 실행하려니, 버전이 안 맞는 에러가 발생했다.TensorFlow가 GPU를 사용하려고 시도했으나, CUDA 또는 cuDNN 라이브러리 초기화에 실패했습니다.tensorflow.python.framework.errors_impl.FailedPrec

doraemin.tistory.com

'dev-setup' 카테고리의 다른 글

| [Azure] 요금 안 나오게 중지 및 해지 (0) | 2025.02.28 |

|---|---|

| [AWS] EC2 인스턴스 생성 및 배포 (0) | 2025.02.27 |

| [PyTorch] Anaconda, PyTorch 설치 및 실행 (1) | 2025.01.17 |

| [Scanpy] 설치 및 실행 (1) | 2024.12.14 |

| conda 가상환경 생성 및 R 실행 (3) | 2024.11.28 |